🎭OpenAI, una storia tragicomica tra finti eroi e rockstar decadute, dove a perdere è l'etica - #10

Caos, drammi e conflitti nella settimana più pazza per OpenAI. E poi, le elezioni in Argentina sono davvero state guidate dall'intelligenza artificiale? Spoiler: No

🦸♂️Decimo numero di Superpoteri!

🦸♀️Chi segue gli sviluppi dell’intelligenza artificiale non si annoia mai. Quando si parla di un capo di un’azienda come di una rockstar è inevitabile che tutto si trasformi in spettacolo. Ma lo psicodramma che si è visto dentro OpenAI non può essere ridotto a un “colpo di testa” di membri del board eretici. Perché è stato cacciato Altman? Cosa c’entra l’altruismo?

🦸E poi, il New York Times ci dice che le elezioni argentine sono state le prime a essere guidate dall’intelligenza artificiale. E’ davvero così? Per chiudere, un video di alleggerimento che ci porta in una Hogwarts alternativa.

🦹♀️Buona lettura, fammi sapere cosa ne pensi e, se non l’hai ancora fatto, iscriviti!

Superpost

🦸♂️Caos. Dramma. Conflitto. Queste sono le uniche parole che mi vengono in mente mentre cerco di dare un senso agli eventi di una delle settimane più tumultuose nella storia della Silicon Valley. Decine di miliardi di dollari di valore sono stati distrutti e ricreati da un giorno all'altro e il destino di una delle più importanti aziende di intelligenza artificiale è stato più volte in bilico. No, non è una allucinazione di ChatGPT, ma una storia piena di caos, drammi e conflitti.

Il caos è cominciato venerdì sera con un colpo di stato del consiglio di amministrazione di OpenAI, che, a maggioranza, licenzia Sam Altman. Non si era vista una cosa simile dal 1985, quando il cda di Apple cacciò Steve Jobs e servirono 12 anni di attesa per rivederlo a capo della società di Cupertino. Ad Altman sono bastati 5 giorni per tornare in sella a OpenAI. Non è necessario essere un esperto in gestione aziendale per pensare che, se intendi licenziare un CEO, non lo accusi di disonestà a meno che tu non abbia una prova efficace, una “smoking gun” come direbbero gli americani, di una violazione etica molto grave. Non solo, forse dovresti avvisare chi ha investito 10 miliardi di dollari nella tua azienda (Microsoft).

E quindi passiamo al dramma. Non sto a elencare tutti i passaggi, anche perché, come una vera e propria serie tv, ci sono continui colpi di scena: la prospettiva di licenziamento in massa dei dipendenti di OpenAI, una possibile fusione con il rivale Anthropic, il pentimento e le lacrime digitali di Sutskever, il capo degli scienziati di OpenAI, considerato la mente dietro la cacciata di Altman. E poi il pronto ingaggio da parte di Microsoft di Sam Altman per evitare che vada da altre concorrenti, la nomina di un nuovo CEO, Emmet Shear, l’ex capo di Twitch. Infine, come una storia a lieto fine, l’eroe Sam Altman che ritorna, acclamato come un imperatore. Insomma, ci sono tutti gli elementi per fare una serie da guardare su Netflix, ma non so se potrebbe essere una tragedia o una commedia.

Il conflitto si è chiuso, con la sostituzione di quasi tutti i membri del board “eretici” che avevano fatto il “colpo di stato” veneredì scorso. La domanda che rimane è: perché è stato cacciato Altman? E perché così in fretta? Per adesso la spiegazione più plausibile è che ci sia stata una forte divisione tra chi aveva un background accademico, capitanati da Ilya Sutskever, cofondatore e capo degli scienziati di OpenAI e chi proveniva dal mondo startup come Sam Altman. Frenatori contro acceleratori? Sembra più uno scontro “culturale”, anche perché gli stessi scienziati di OpenAI non volevano frenare il progresso dell’intelligenza artificiale, ma le “derive decisioniste” di Altman. Sui motivi abbiamo solo speculazioni, con due teorie interessanti:

la prima è che Sustkever credesse che Altman fosse coinvolto in altre, troppe iniziative non legate agli obiettivi espressi nella carta fondativa di OpenAI, come ad esempio diventare un concorrente di NVIDIA per produrre l’oro del momento, i chip per sviluppare AI, o creare una società di hardware dedita alla costruzione di smartphone potenziati. Inoltre Altman viene accusato di non aver chiarito le aggressive strategie di raccolta fondi con i regimi autocratici del Medio Oriente, che potrebbero utilizzare la tecnologia di intelligenza artificiale di OpenAI per costruire sistemi di sorveglianza digitale o consentire violazioni dei diritti umani.

Un’altra teoria, più preoccupante, è che OpenAI abbia fatto un passo avanti nella ricerca che ha davvero spaventato Sutskever, e che Altman volesse procedere con la commercializzazione troppo rapidamente. Il giorno prima che Altman venisse licenziato, parlò ad un panel con altri amministratori delegati al vertice dell'APEC (Asian-Pacific Economic Cooperation), dove disse :

"A titolo personale, quattro volte nella storia di OpenAI ho pensato che fossimo riusciti a squarciare il velo dell’ignoranza. L'ultima volta è stata solo nelle ultime due settimane. E riuscirci è l’onore professionale di una vita”.

Magari Sustkever aveva una valutazione dei rischi diversa da quella di Altman e da qui la necessità di “rallentare” il rilascio al pubblico di nuove versioni di ChatGPT.

Forse la verità è un mix tra le due teorie, forse è un’altra ragione a noi nascosta. Diciamo che da chi ha accusato Altman di scarsa trasparenza ci saremmo aspettati maggiore chiarezza.

E’ sempre stato chiaro che OpenAI stava cercando di costruire l’intelligenza artificiale generale (AGI) e di costruirla il più velocemente possibile, dicendo in ogni occasione che potrebbe essere estremamente pericolosa e che i governi dovrebbero essere coinvolti per controllarla, assicurandosi però che nessun altro potesse svilupparla tranne loro. E’ in questo dilemma etico che si è consumato il dramma della governance di OpenAI. Siamo davvero così vicini all’intelligenza artificiale generale? Ovviamente non lo so, e sembra che nessuno possa saperlo concretamente, in quanto l’intelligenza umana resta ancora un mistero.

Quello che sappiamo è che la maggioranza dell’ormai vecchio board di OpenAI aveva un forte legame con una corrente filosofica chiamata “effective altruism”, altruismo effettivo, un misto di etica applicata, tecnologia speculativa e filantropia. Un movimento influenzato dall'utilitarismo tecnologico che serpeggia nella Silicon Valley, dove sono i più ricchi a decidere come salvare il mondo, massimizzando l'impatto filantropico attraverso approcci basati sull'evidenza pragmatica.

L'altruismo efficace è stato criticato per la sua distanza dai problemi del quotidiano e per il suo focus sui rischi a lungo termine, come l'intelligenza artificiale distruttiva o la guerra biologica, ignorando i problemi attuali come i bias di genere e razziali ed evitando di risolvere i problemi strutturali. Questo approccio isolato ha limitato la partecipazione da parte di altri gruppi della società civile, facendo degli esponenti dell’altruismo effettivo un “club” riservato ed elitario.

Non se se nel finale hanno vinto i “buoni”, se Sam Altman è davvero un eroe di questi tempi. Di sicuro conosciamo gli sconfitti, i “filosofi” del board, in favore di chi sa muoversi meglio nel mondo cinico e spietato della Silicon Valley. Hanno fallito, e con loro l'ambizione utopistica di usare aziende originariamente create come no-profit per sviluppare sistemi di intelligenza artificiale avanzata che hanno come obiettivo quello di cambiare il futuro dell'umanità e rivoluzionare l'economia, reclutando i migliori informatici disponibili. Alla fine non serve una grande intelligenza per capire che il motore di crescita delle startup è quanto valore riesci a creare per gli investitori e che, nell’attrarre capitali, l’altruismo di facciata e l’etica a intermittenza non pagano.

Se si vuole costruire una tecnologia che aspira davvero a risolvere i problemi, non possiamo prescindere dall’intervento del pubblico, dal senso di comunità collettiva, dai lunghi, ma necessari processi di partecipazione e coinvolgimento. Può essere meno interessante che parlare di intelligenza artificiale, ma supportare e sostenere la democrazia è ancora la forma di altruismo più efficace che conosca.

SuperPolicy

🦸♂️Il 2023 si sta concludendo con l’ennesima sorpresa elettorale: in Argentina ha vinto l’anarchico-ultraliberista Javier Milei. Non mi soffermo sul personaggio (sigh!), ma sul fatto che il New York Times, ripreso da Wired Italia, ha decretato che queste elezioni sono state le prime guidate dall’intelligenza artificiale. E’ stato davvero così?

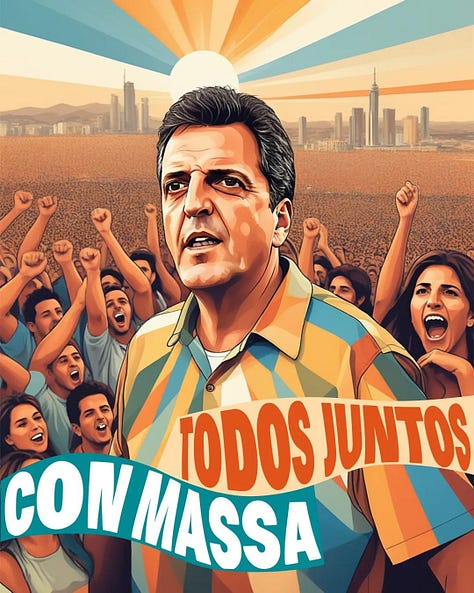

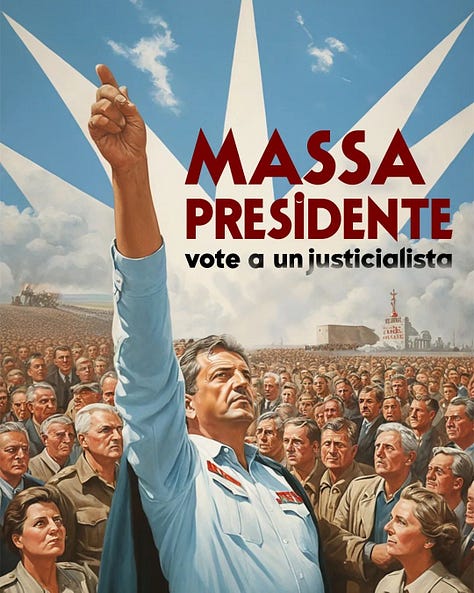

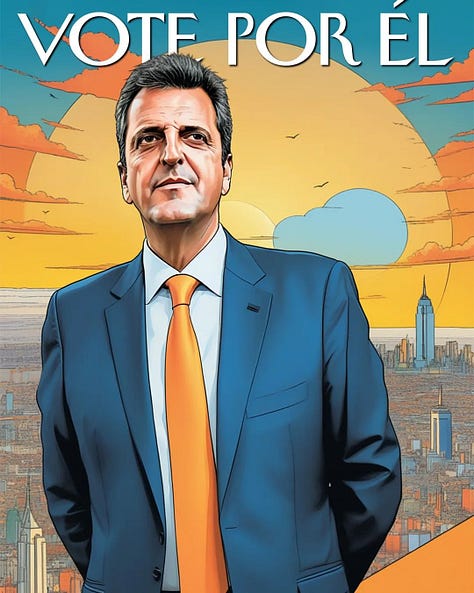

Negli articoli si cita soprattutto un account IG, iaxlapatria, che ha pubblicato alcune immagini generate dall’AI che vedono protagonista lo sconfitto Massa in poster ad alto contenuto propagandistico, esaltandone la forza e il carisma:

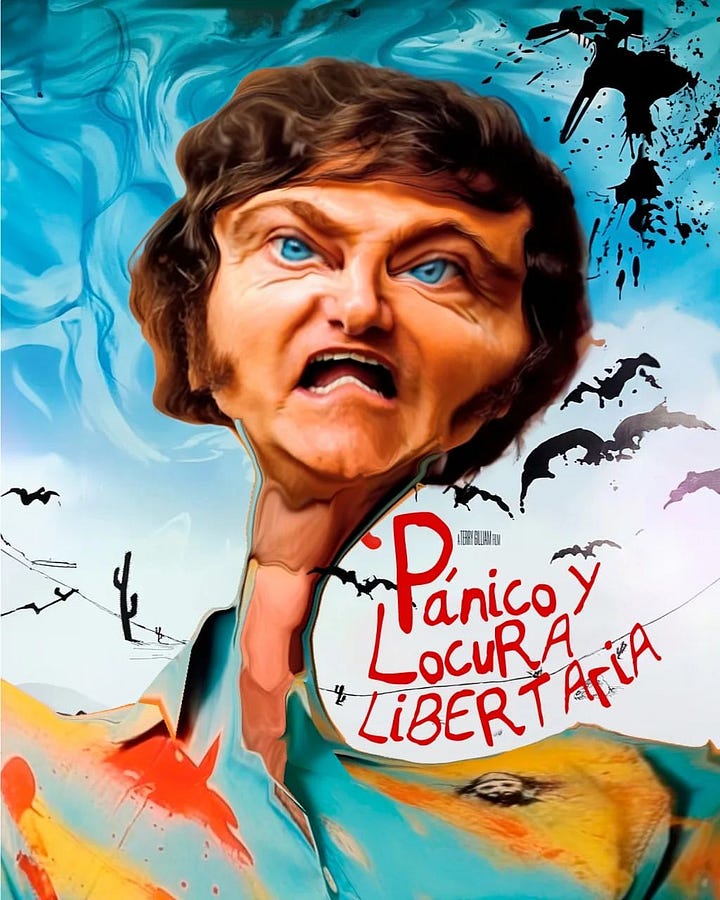

Lo stesso account, che ha solo 6000 followers, ha pubblicato anche dei video e delle immagini fake che dipingono Javier Milei, l’altro candidato, come instabile e matto, facendolo diventare come i protagonisti instabili e di alcuni film famosi (Paura e delirio a Las Vegas e Arancia Meccanica):

Massa stesso, sorpreso dalle capacità dell'IA, ha espresso disaccordo con l'uso di deepfake che ritraevano Milei in modo inappropriato, prendendo le distanze dall’account IG.

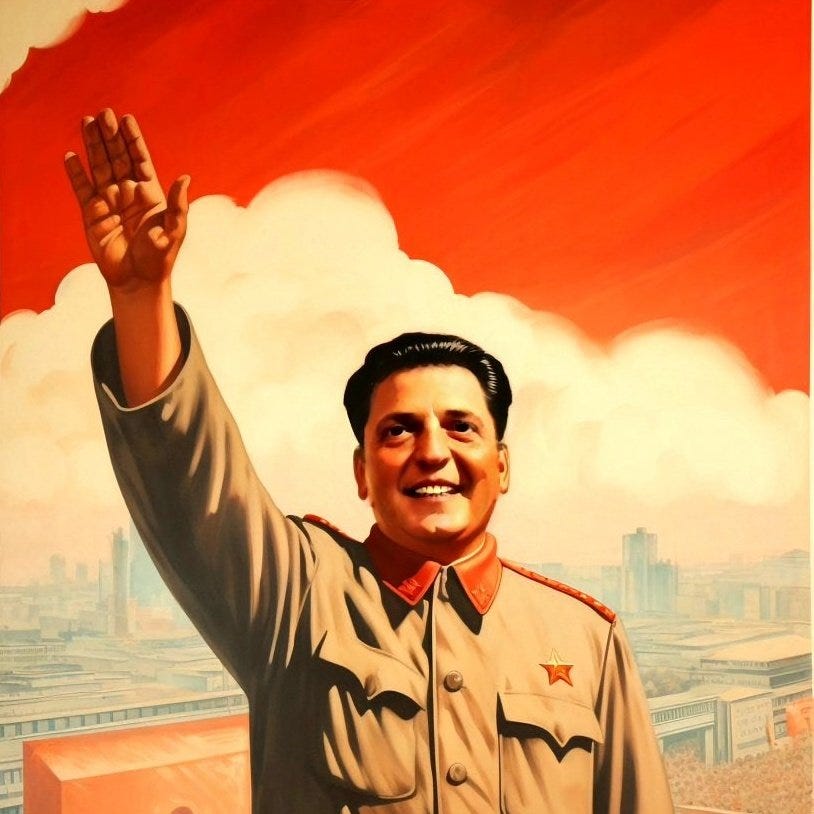

🦹♀️L'altro candidato, Javier Milei, ha risposto condividendo immagini IA che ritraggono Massa come un leader comunista cinese:

Questa immagine ha avuto 3 milioni di visualizzazioni, ma niente di più di qualsiasi altro contenuto postato da Milei.

Poco altro viene citato dall’articolo del New York Times, se non un introvabile video deepfake in cui Milei spiega il mercato degli organi umani, in linea con le sue viste libertariane.

🦹♂️Se questa è la paura che dovremmo avere per l’intelligenza artificiale nelle elezioni possiamo stare tranquilli. Non saranno certo le poche centinaia di like alle creazioni di un account Instagram poco seguito a cambiare le sorti di una elezione. Purtroppo i rischi sono più di una simpatica parodia di una locandina del film, che può togliere al massimo lavoro a qualche grafico. Gli utilizzi futuri dell’intelligenza artificiale potrebbero essere più preoccupanti, come ad esempio agenti AI convincenti che potrebbero essere utilizzati in campagne di persuasione su larga scala. Inoltre, la semplice presenza di deepfake nel 2024 potrebbe minare la fiducia nelle fonti di informazione essenziali e creare ancora più confusione.

🦹Nel prossimo anno le più grandi democrazie andranno al voto: India, Europa, Gran Bretagna e America. Meta, la società proprietaria di Facebook e Instagram, ha dichiarato che richiederà agli annunci politici di rivelare se utilizzano l'intelligenza artificiale e c’è la stessa valutazione dalla Commissione elettorale federale degli Stati Uniti. L’obiettivo finale è evitare di ricordarci le prossime elezioni come le prime fortemente manipolate dall’intelligenza artificiale, ma lavorare affinché anche il futuro della tecnologia (come usarla, come può aiutarci a risolvere i problemi) sia tra i temi da discutere come proposta politica.

Supervideo

🧙♂️Stanchi dalla troppa lettura? Rilassatevi con questo video di un immaginario rave party ad Hogwarts con la musica di Trainspotting e immagini generate da IA. Non vorreste partecipare a una festa così?

👏Ed eccoci arrivati alla fine di questa decima uscita di Superpoteri. Speriamo che in Silicon Valley si siano calmati, spiegandoci davvero cosa è successo dietro la cacciata di Altman.

🫵Ricordatevi che Superpoteri è un esperimento collettivo, utile per generare dibattiti, riflessioni, proposte sulle tecnologie e il loro impatto. Nessuno si deve sentire escluso.

🤖Puoi darmi una mano semplicemente iscrivendoti (se non l’hai ancora fatto) cliccando sul pulsante sotto.

🦸♀️Puoi lasciarmi un commento (anche critiche, dai!) o scrivermi per qualsiasi suggerimento

🦸Infine puoi semplicemente condividere “Superpoteri” a chi pensi possa essere interessato

Grazie e ci vediamo settimana prossima!👋